Abschlussarbeiten

Verteidigungstermine

| Datum | Zeit | Raum | Kandidat/-in | Thema | Gutachter |

|---|---|---|---|---|---|

| 16.12.2025 | 15:00 Uhr | M 123 | Franz Schmidt | Entwicklung eines Workflows zur Akquise von Bodenradardaten (GPR) unter Berücksichtigung echtzeitkinematischer GNSS-Daten | Prof. Dr. rer. nat. Martin Oczipka, Dr.-Ing. Alvand Miraliakbari |

Ausgewählte Abschlussarbeiten

Masterarbeit von Ingmar Richter (2025)

Paradigmen, Funktionalität und Validierung der 3D-Koordination mit BIM und GIS

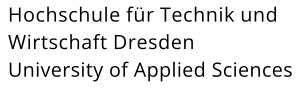

Diplomarbeit von Roman Gurtner (2025)

Untersuchung zur Erstellung von openBIM-konformen Umgebungsmodellen und Bestandsmodellen in BricsCAD BIM

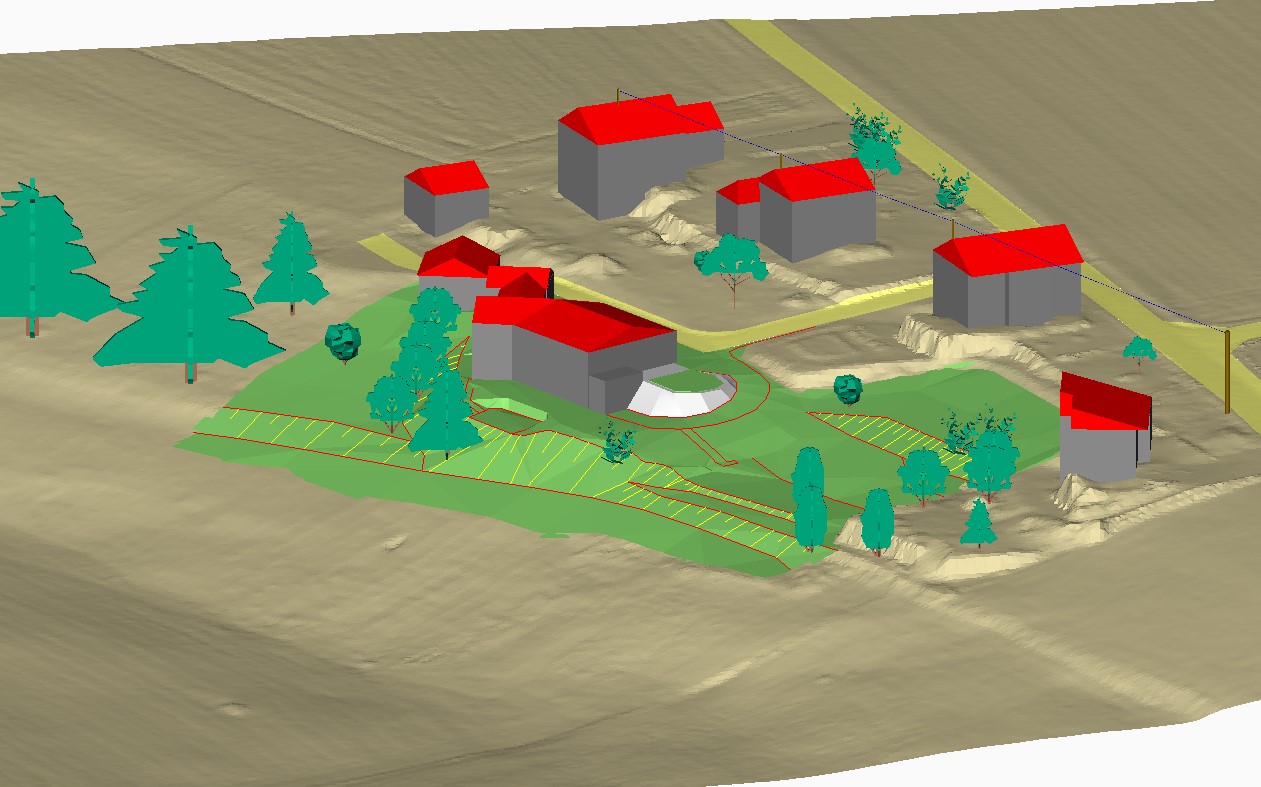

Bachelorarbeit von Philipp Eley (2024)

Erstellung einer Webapplikation des NascaGIS unter Verwendung von Open-Source

Bachelorarbeit von Anne Sophie Bräuer (2023)

3D-Modellierung und Präsentation des Uranerzbergbaus bei Aue-Bad Schlema von den Anfängen bis zur Gegenwart

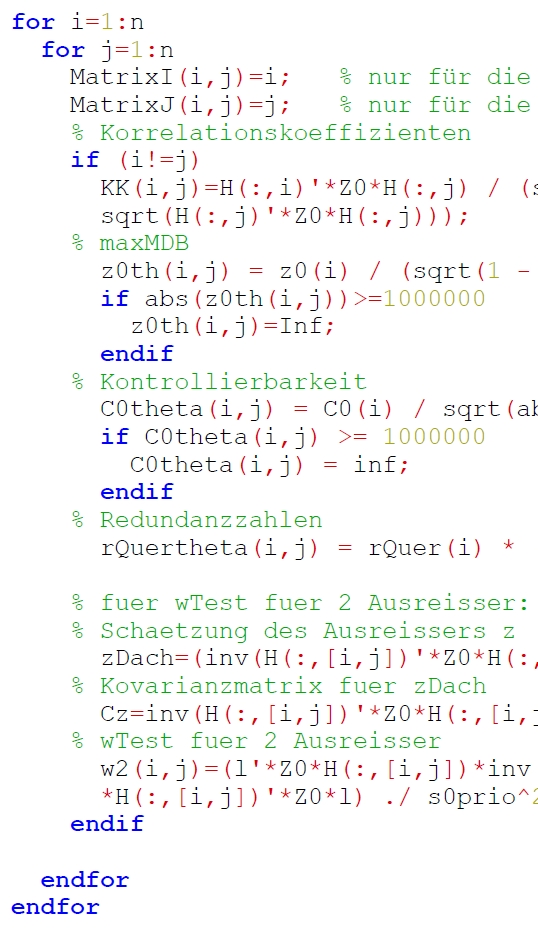

Bachelorarbeit von Samuel Hagist (2023)

Untersuchungen zur Kontrollierbarkeit und Aufdeckbarkeit von multiplen Ausreißern in geodätischen Koordinatentransformationen

Bachelorarbeit von Celina Tillig (2025)

Methoden zur semantischen Annotation von Building Information Modelling (BIM) Modellen zur Förderung der Nachhaltigkeit im Bauwesen

Bachelorarbeit von Cara Basche (2024)

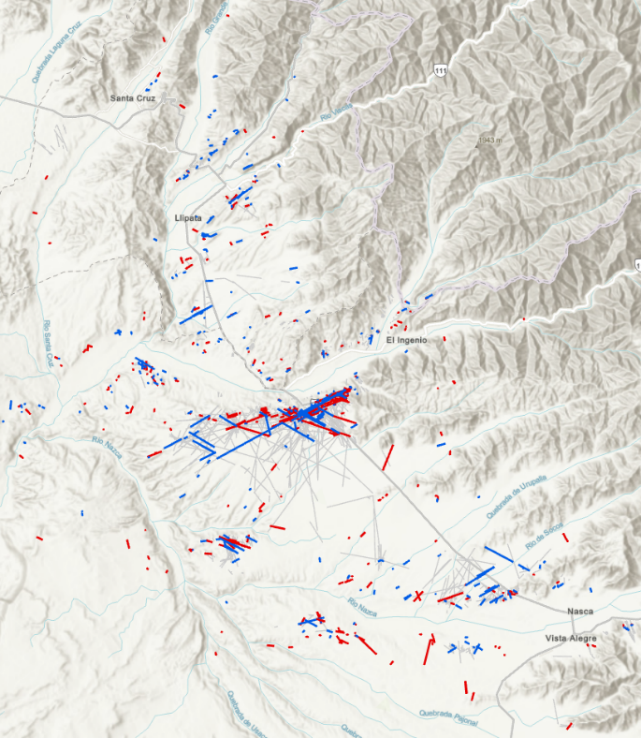

Astronomische Untersuchung zur Kalendertheorie der Linien von Nasca/Peru hinsichtlich der Mondbahn

Bachelorarbeit von Manuel Freiwald (2024)

Bestimmung und Analyse sümpfungsbedingter Bodenbewegungen in einem Braunkohlerevier durch Kombination von GNSS und Tachymetrie

Bachelorarbeit von Alfred Paul (2023)

BIM-Paradigmen für das verformungstreue Aufmaß – Softwarevergleich am Beispiel eines Dachstuhls

Weitere Links

Weitere Dokumente/ Antragsformulare finden Sie hier: https://www.htw-dresden.de/hochschule/fakultaeten/geoinformation/studium/abschlussarbeiten